ふとしたきっかけでMS製のPC、SurfaceProに興味が出たのよ!

当然、中古ジャンクよね?

えー(笑)5台を調達しました。

好きねー!で、ベトナムに持っていったの?

MS製ノートPCの代名詞、サーフェイス(Surface Pro)です。今までこのPCには興味がなかったのですが、とあるYouTubeの動画を見たらめっちゃ欲しくなりました。その動画はmacosを入れてタッチペンでお絵描きしていたんですよね。まずは見てみてくださいな。

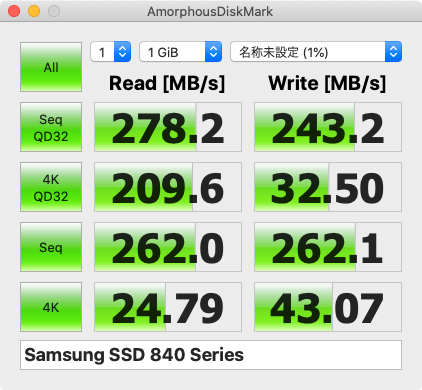

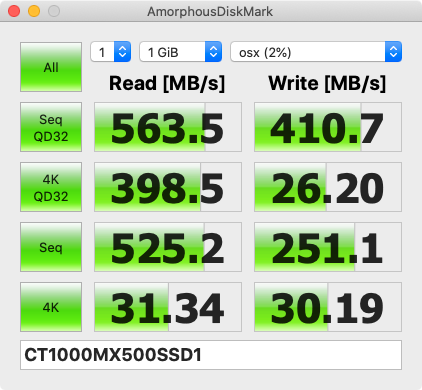

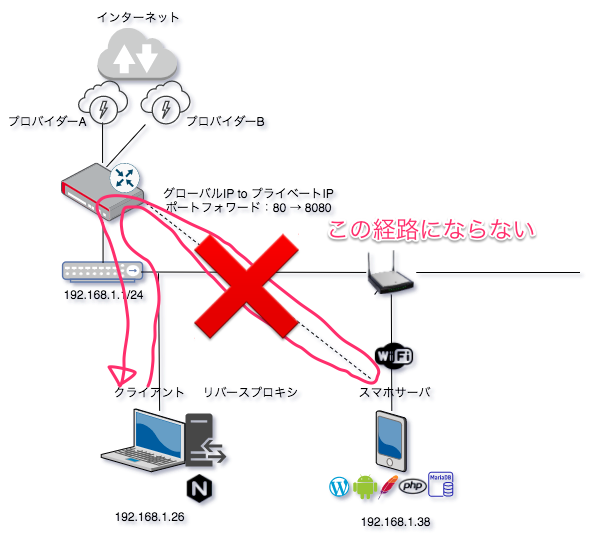

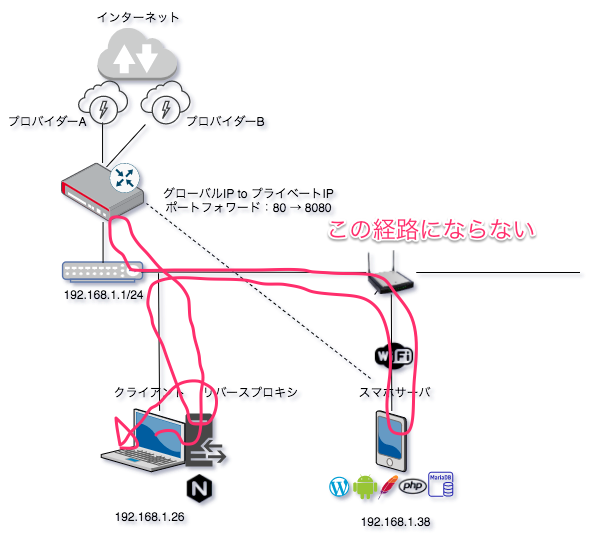

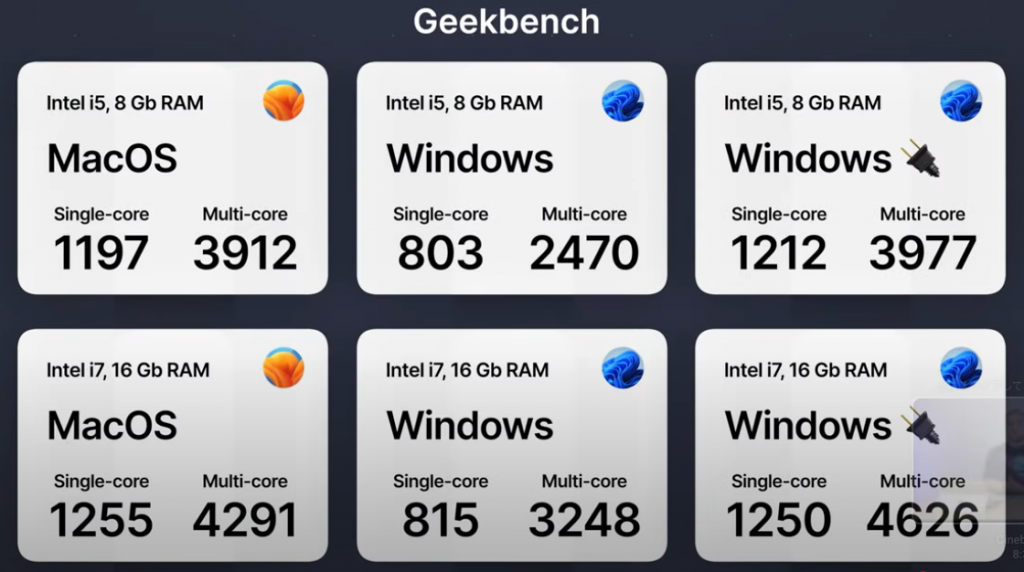

この動画では、Surface Pro7 を使っています。Windowsとベンチマーク比較しているのですが、macosのほうが速いみたいですね。

ということで、俄然このノートPCが欲しくなりました。はい、理由は単純。「macosでタッチ操作してみたい」が動機です。液タブみたいに使えるのか?など疑問がいっぱいで、その確認してみたい気持ちが抑えきれなかったというやつです。

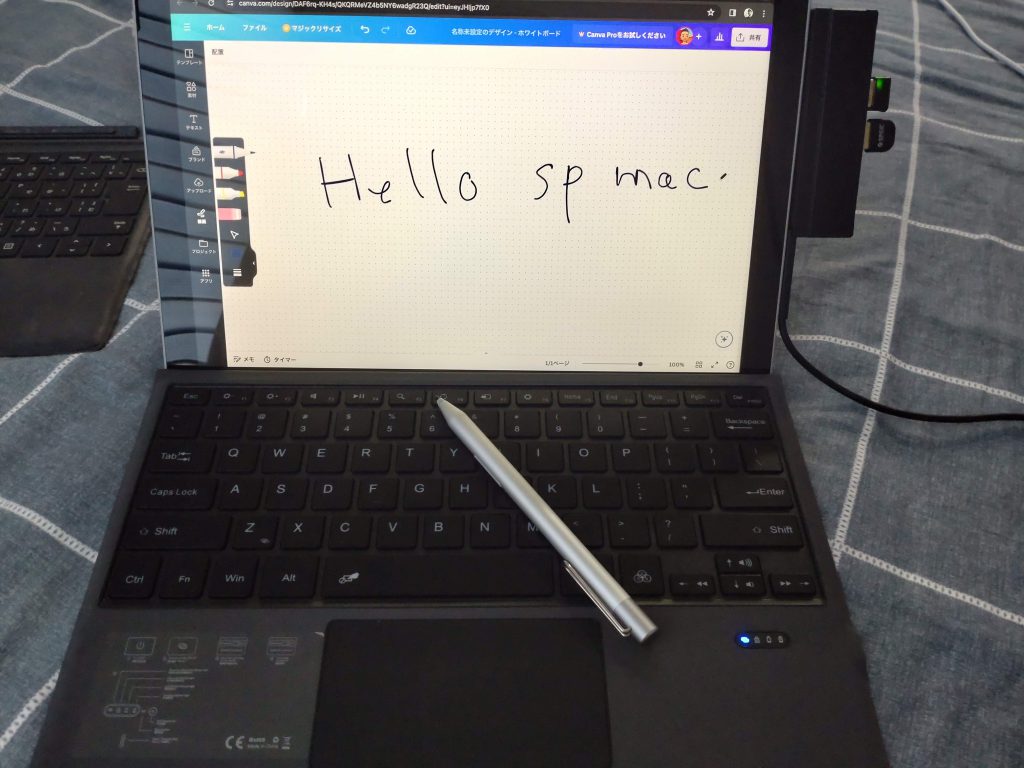

以下画像は、予算の関係でSurface Pro6や5でのHackintoshした画面です。

まだ調査中で、使い出して間も無いのですが普段仕事でmacos使いのエンジニアがこのマシンをどのように感じるか? また、どのような使い道があるのか? などのレポートを長期で書いてみたいと思います。

まずは、Surface Proの中古相場を検討する

普段はベトナム・ホーチミンに滞在しているのですが今は年末なので一時的に日本に帰国しています。日本には、ヤフオクやメルカリがあるので中古機器をゲットするには最高の環境なんですよね。

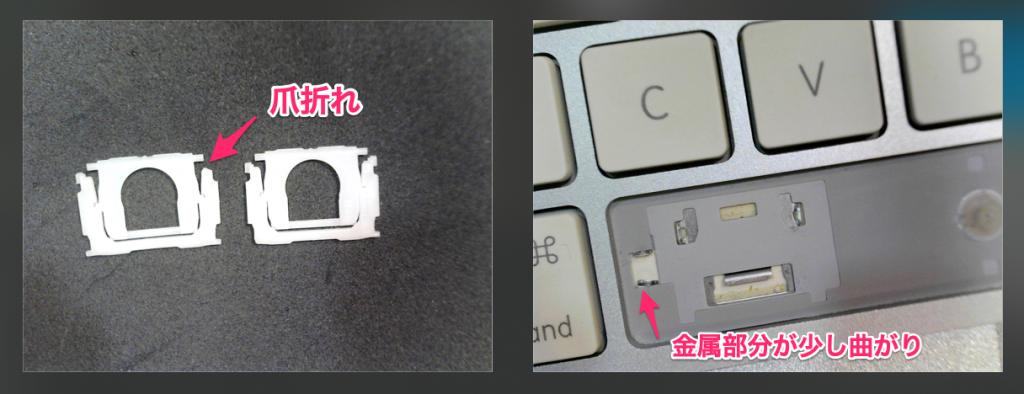

で、今までMS製のSurface Proはオフィスでは他人が使うのを見たことがありますが、自分では使ったことがありません。印象としては、キーボードがペラペラな壊れそうなPCだなーっていう印象しかありませんでした。実際、外部モニター出力の接触は悪くなっている筐体がたくさんあったようで、MTG時にモニターに接続するときは結構大変みたいでした。あと、キーボードはタワむとその人は言っていました。

しかし、中身(OS)をHackintosh化してmacosで運用できるなら話は別です。ヤフオクであれこれ物色した結果、機種にもよりますが、画面割れは5000円〜2万円くらいです。正常な個体は、1万円〜5万円くらいはします。まだSurface Pro7+ は新品も売っているようですね。

この筐体選びは、かなり重要で本当はSurface Pro7か7+が欲しかったのですが予算の関係で落札できませんでした。ということで、Surface Pro5と6 を検証していきたいと思います。

Hackintosh化できるSurface Proは?

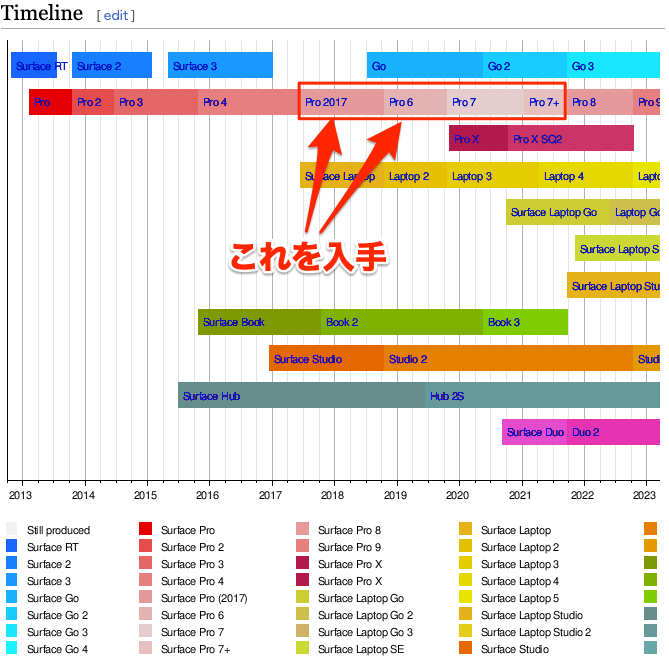

いろいろと調べていくうちに、Surface ProをHackintosh化するには一番良いのが、Surface Pro7 または、ストレージが拡張できるSurface Pro7+ が良いようです。そもそもSurface Proは型番がたくさんありますのでWiki見た方が速いです。

ざっくり説明すると、2017年に発売されたSurface Pro(無印)がSurface Pro5とかSurface Pro 2017とか呼ばれています。なんでこの時の製品名に5が付かなかったのかは知りませんが、これ移行は、6・7・8・9とSurface Proの後ろに番号が付くのが製品名になっています。Hackintosh化するにあたり、Surface Pro7か、Surface Pro7+ が最適解かと思います。理由は後で。

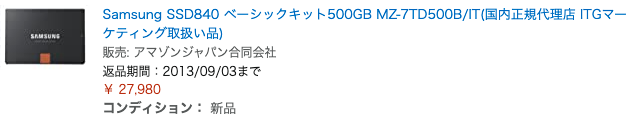

Surface Pro7(とプラス)は結構人気で、3万円以上になってなかなか希望額では落札できませんでした。特にプラスがついたモデルはストレージがマザーに直付けじゃなく後から交換できるタイプで、相場は4〜5万前後することもあります。安い時は3万円台くらいで買えるかもです。

イオシスの新春特売でまずは2台ゲット

何回の落札に敗れ、落札できず仕舞いでした。こうなるともう末期患者です。(笑)

そうこうしている内に、Surface Pro5(正式な型番は5がつかないもので、2017製)が、新春特売で売られていたので店舗へ足を運んでみることに。イオシスの特売です。

(1) surface pro5 4G/128GB Core m3-7Y30・・・16777円

(2) surface pro5 LTE 8G/256GB i5-7300U・・・30000円

(1) を買うはずが、衝動買いで(2) も買ってしまいました。LTE通信に興味があってタイプカバー日本語もついていたので、ついつい。

スペックは以下のWIKIを見るとわかりやすいです。

WIKI:Surface Pro シリーズ(LINK)

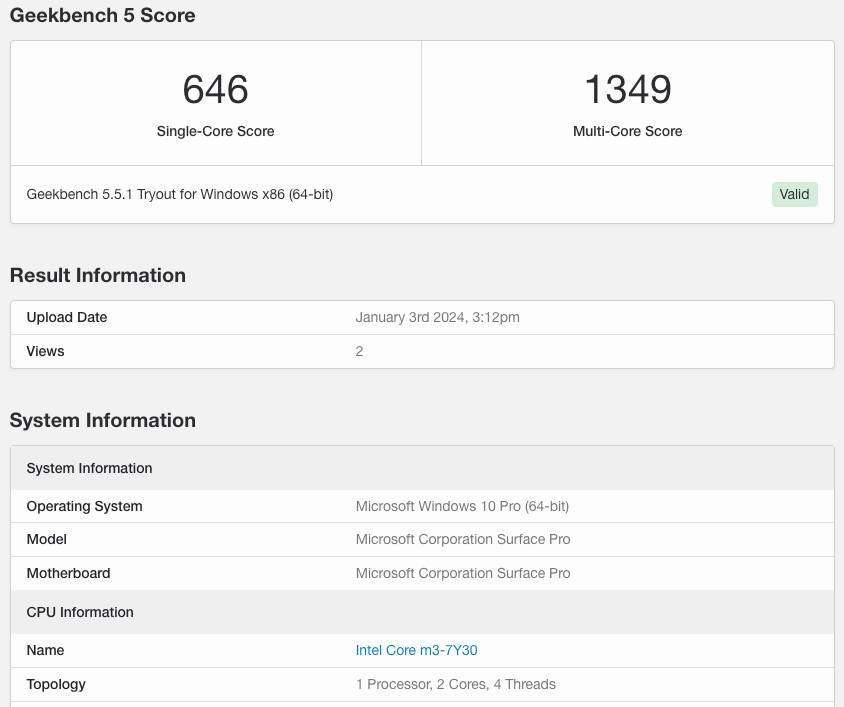

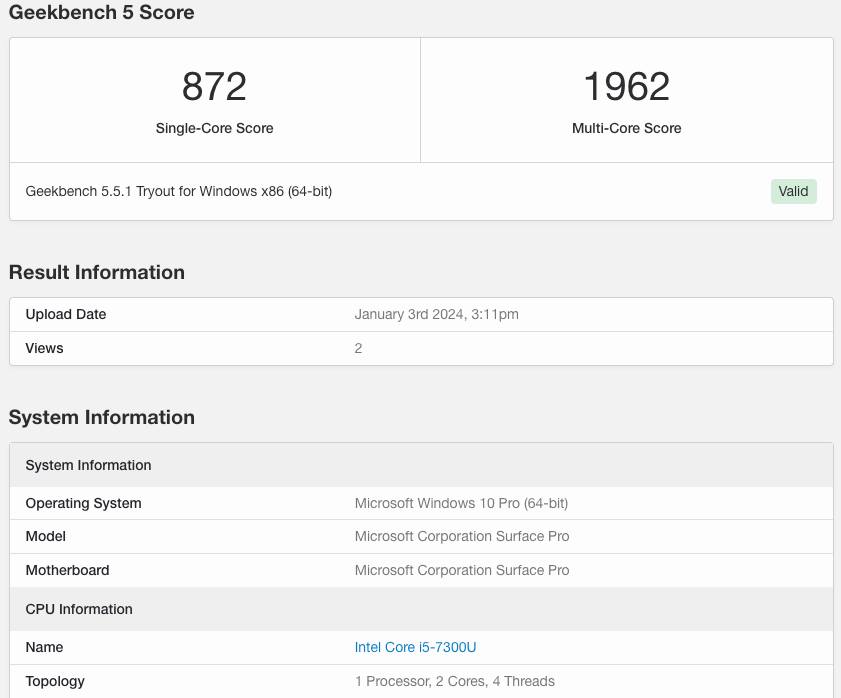

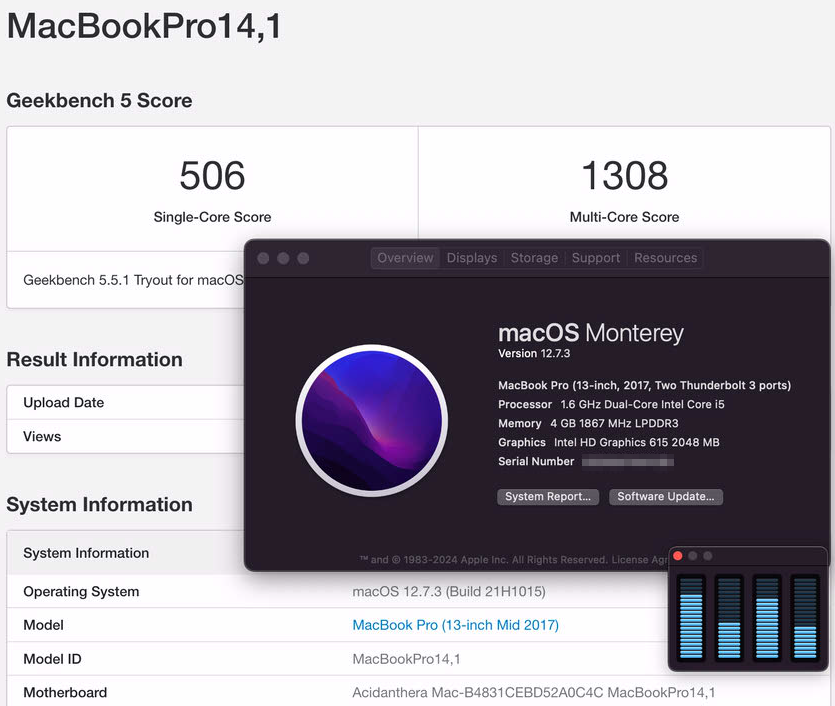

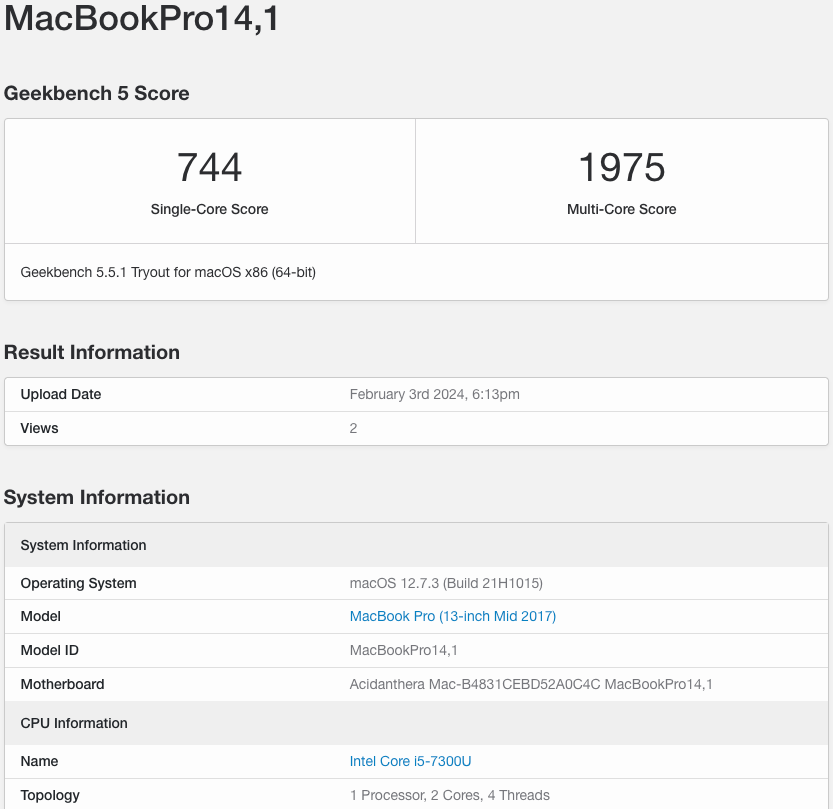

Windows10でGeekbench5 を走らせた結果が以下です。

Windows10でGeekbench5 を走らせた結果

(1) surface pro5 4G/128GB Core m3-7Y30・・・16777円

こっちは印象としては、Winマシンとしては辛そうです。macとしては入れてみないとなんとも言えませんが、用途を限定して使う感じになりそうですね。

(2) surface pro5 LTE 8G/256GB i5-7300U・・・30000円

まぁまぁ似たようなスコアですね。メモリが8GBってのとDISKが256GBあるのが嬉しいです。人にもよると思いますがちょっとした用途なら、これで問題ない感じです。

macos12でGeekbench5 を走らせた結果

(1) surface pro5 4G/128GB Core m3-7Y30・・・16777円

(2) surface pro5 LTE 8G/256GB i5-7300U・・・30000円

ヤフオクでも落とす

ウォッチリストに入れて観察すること1週間。なかなか希望のは落とせませんね。人気です。結局、以下をゲットしました。

(3) surface pro6 8G/128GB i5-8350U・・・10000円(画面割れ大)

(4) surface pro5 LTE 8G/256GB i5-7300U・・・8000円(画面割れ小)

Surface Pro7かプラスが欲しかったのですが、安くはないですね。まぁ、仕方ありません。ベトナム帰国までに落札して配送完了する必要があったので、今回はSurface Pro7は諦めました。

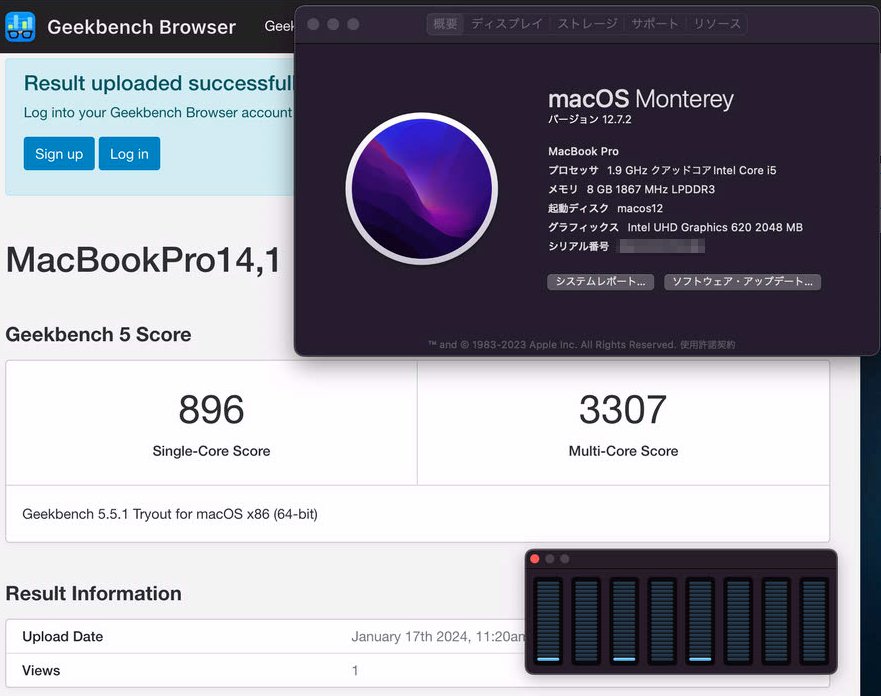

全部で、5台を調達しました。Surface Pro6 のGeekbenchは以下です。今あるSurface Proの中では一番スコアが良いですね。

(3) surface pro6 8G/128GB i5-8350U・・・10000円(画面割れ大)

画面割れは、ベトナムの修理屋さんにMS純正品のパーツで交換してもらいました。約1.6万円

5台を持っていざ、ベトナムへ

ベトナムには、大量の中古PC機械は持ち込めないことになっています。が、自分の場合はベトナムに会社があり、そこで自分が利用するというテイで入国しました。いつもは、スーツケースにデスクトップPCとノートPCを入れて運搬しているので、PC機器は2台ですが、今回はデスクトップを入れて6台。

果たして無事に入国できるでしょうか。

ビザは自分の最近作ったベトナムの会社から自分に発行したD3のビザがあるので、ほどなく取得し、入国。最後、出口のチェックで荷物を開けて確認がありました。自分が使うPCであること。そして、自分がIT関係の仕事をしている旨を伝えると、OKと通してくれました。さすがに5台はやりすぎたか?2台くらいだとノーチェックですが。

持ち込み状態は、ダイソーのソフトケースに入れて箱っぽいものは無い状態だったのですが、レントゲン・チェックで複数のノートPCっぽい形状を確認したのでしょう。1、2台だったら問題ないと思いますが、5台以上を持ち込む場合はこういうチェックはちゃんとあるようです。

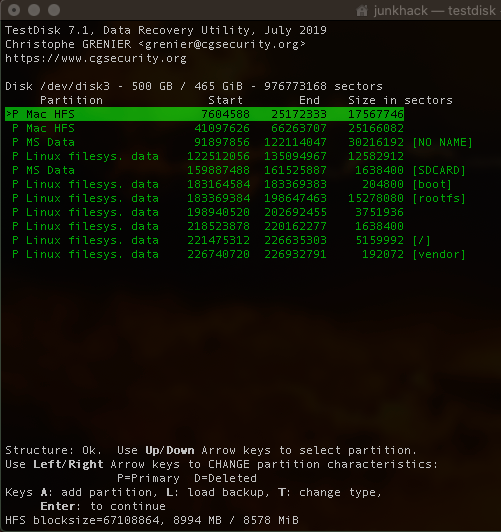

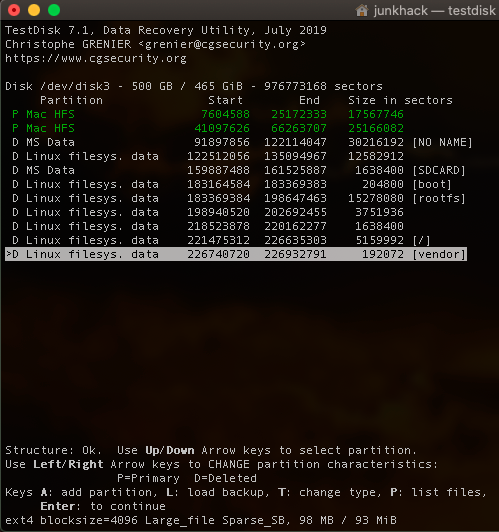

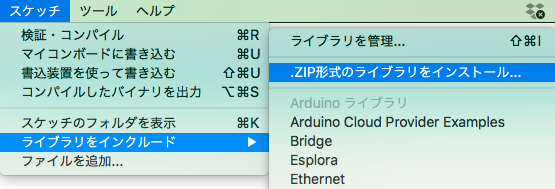

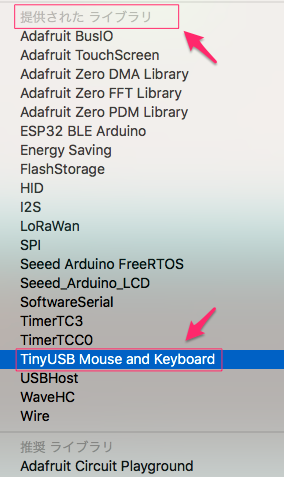

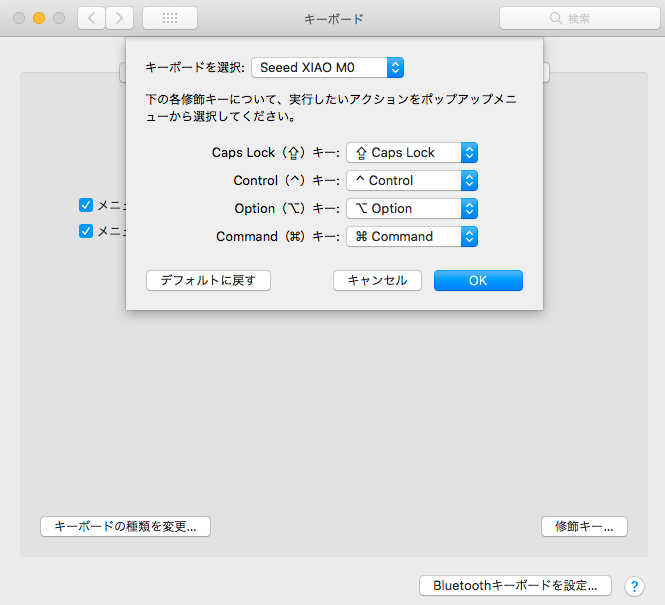

Hackintosh化へ

日本でもある程度はインストールしていましたが、細かいチューニングはベトナムから空き時間にあれこれやっていました。細かい話は面倒なので、機会があればまた紹介しますが、気になる方はGitを見てみてください。OpenCoreのEFIなど、surface5と6のがあります。

GIT:Surface Pro5-6 efi(LINK:そのうち整備予定)

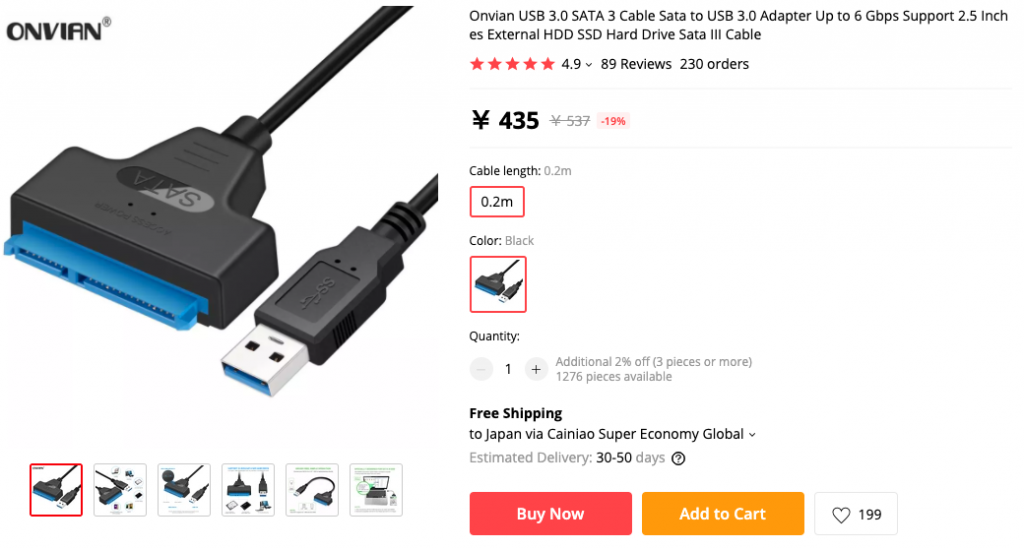

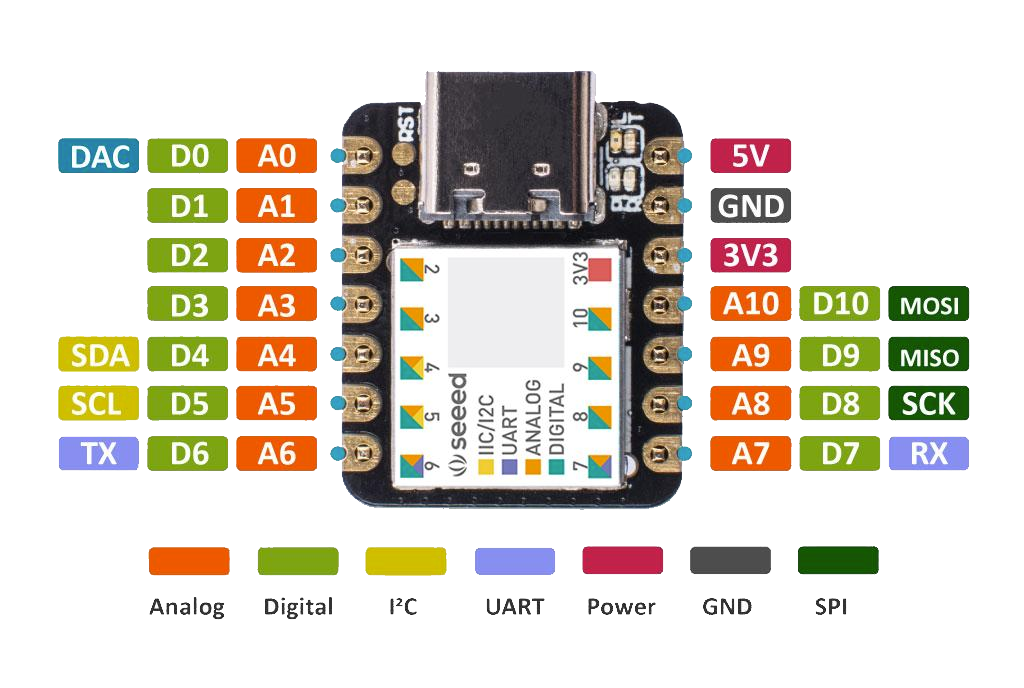

推奨の機材は次で紹介しておきます

周辺機器を揃える

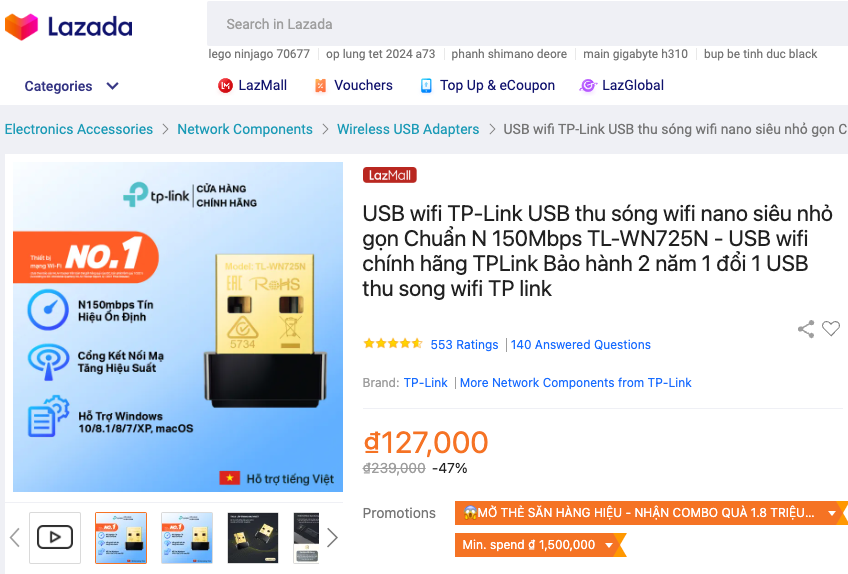

Surface Pro5や6の場合は、内臓のWiFiとbluetoothが使えません。Linuxでは使えることは確認したのですが、macos向けにはまだドライバをだれも作っていないようです。

ということで、WifiとbluetoothはUSBの以下で対応。HUBも以下2種類は稼働し、HDMI出力も可能でした。

●WiFi・・・TL-WN725N

●bluetooth・・・BT-403

●HUB・・・安いのと高いもの2タイプをゲット

イーサネット内臓のタイプも調達

ペン・・・互換ペン

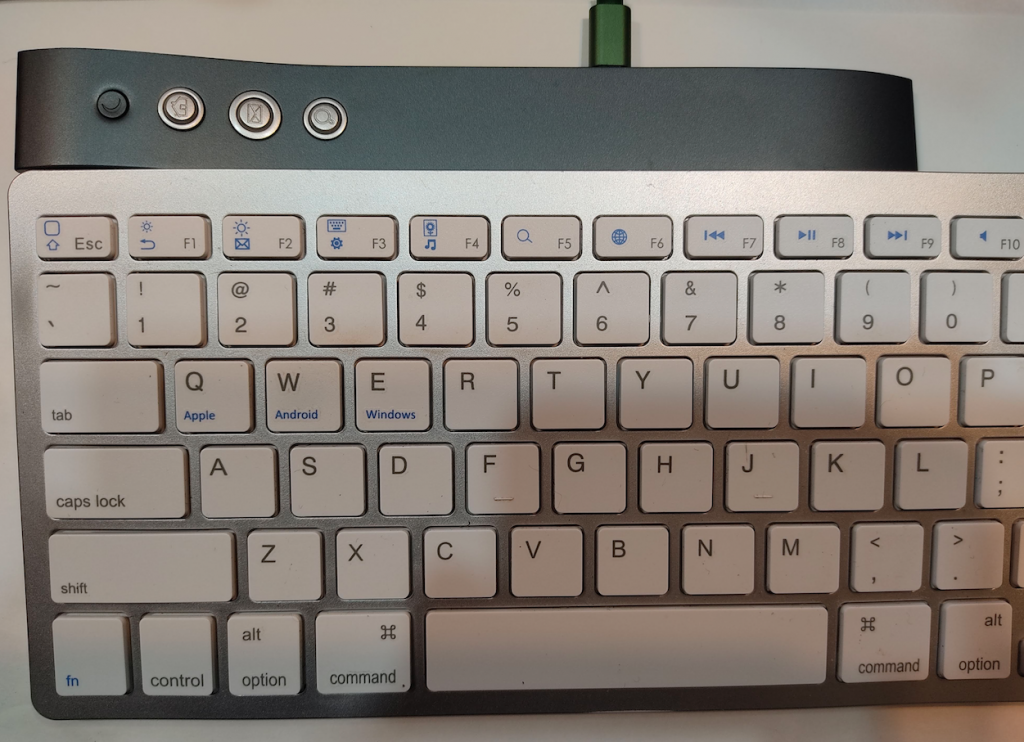

キーボード・・・MS純正USキーボードの中古

Hackintoshとして利用可能と不可な機能

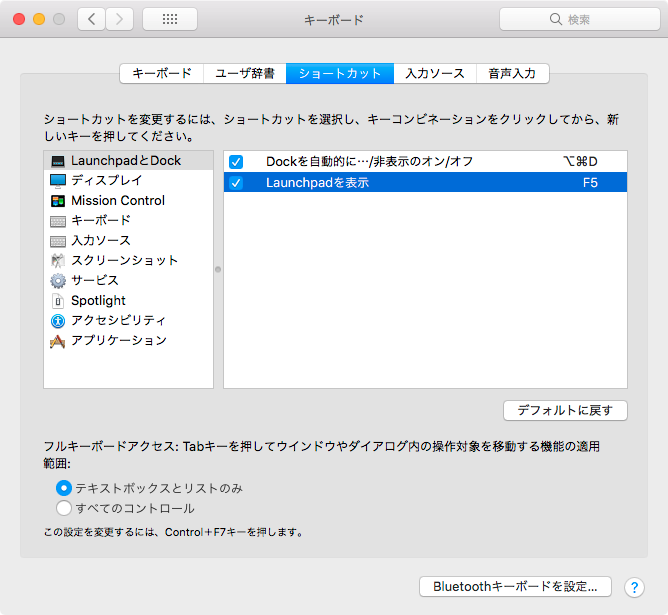

- タッチパネル・・・・使えます

- ペンでお絵描・・・・筆圧感知もあり使えます

- WiFi・bluetooth・・・内臓は不可(上記USBで代用)

- イーサネット・・・・上記HUBは利用可能

- HDMI出力・・・・・edidをオーバーライドするとピンク色が修正可能

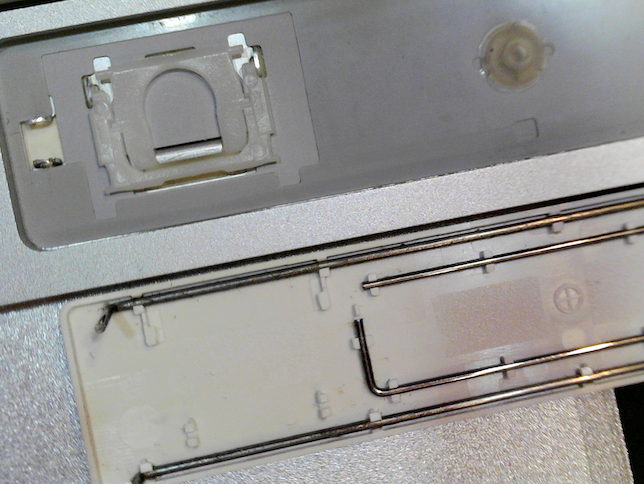

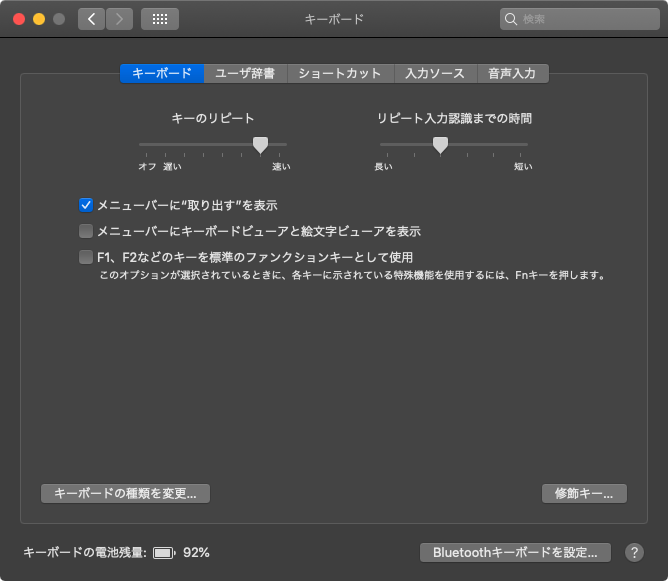

- キーボード・・・・・MS純正のタイプカバーの照度・音・など使えます

- トラックパッド・・・MS純正のタイプカバーでマルチタッチが使えます

- ヘッドフォン・・・・問題なし

- スピーカー・・・・・問題なし

導入の具体的な方法は、興味のあるかたは各自で頑張ってください。どこかで自分用にメモするかもですが。

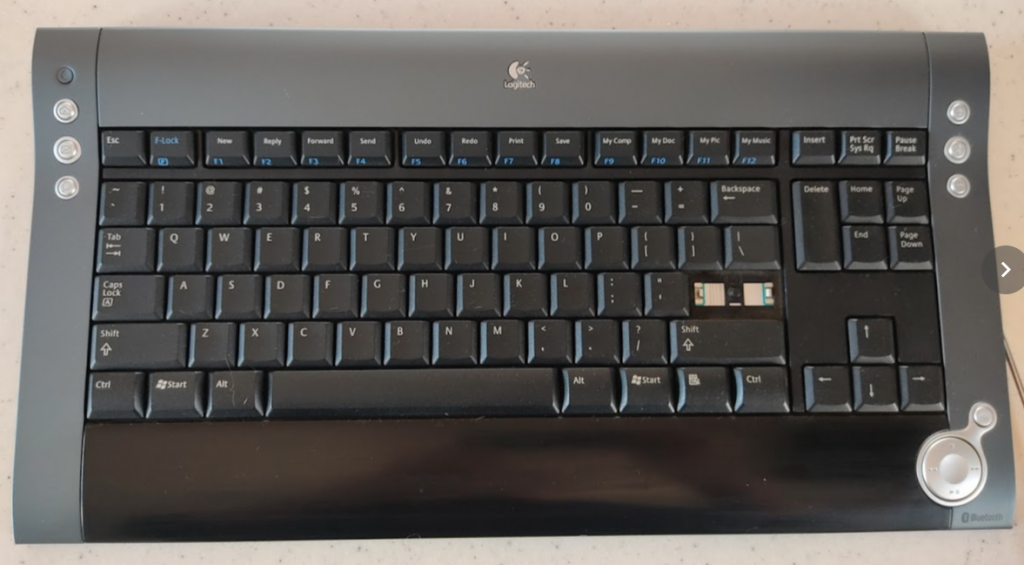

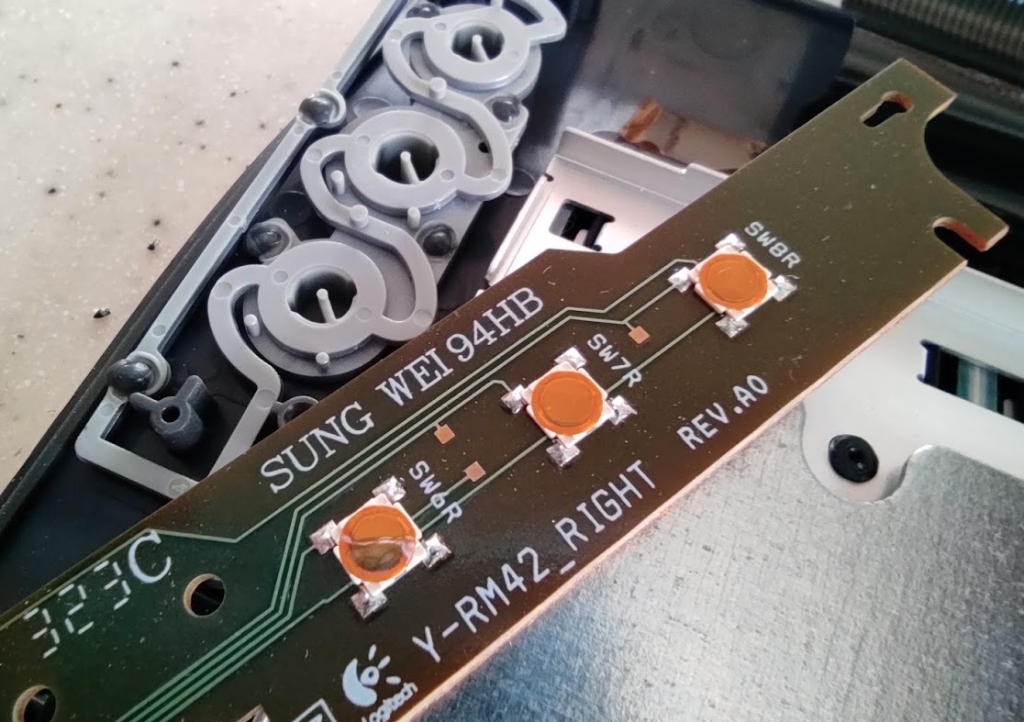

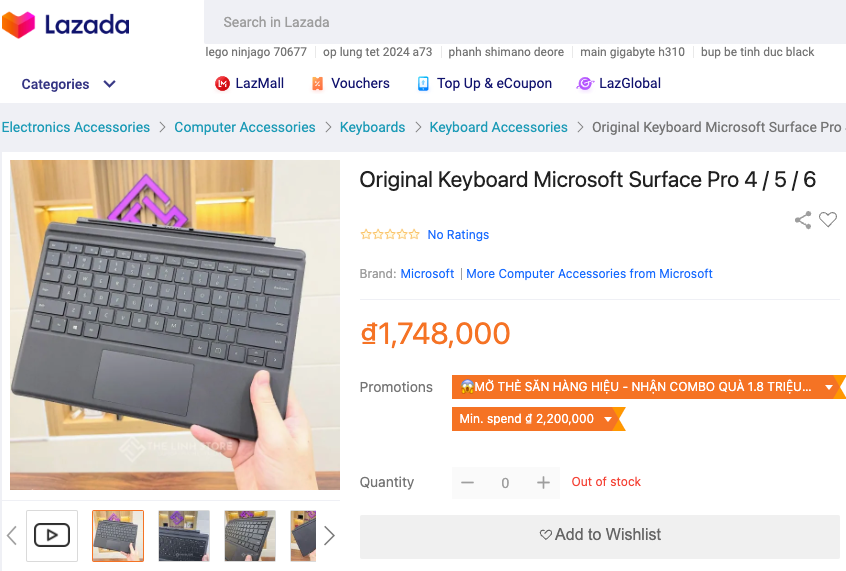

購入して失敗したなと思った機材

- bluetooth接続のサードパーティー製Surface Proキーボード

これなんですが、購入するまえは同じものかと思っていたのですが、実際はMS純正のタイプカバーキーボードとは違って、金属の接点がないんですよね。つまり、接続はbluetoothオンリーです。

取り外して使えるメリットはあるんですが、いざ使うときに接続が切れて再接続まで若干のラグがあったり、そもそもキーボードはよくある中華製のキーボードでタイプの質感が悪いんですよね。

英語配列が欲しかったので3000円くらいだったしまぁ、安いからいいかって感じで購入したのですがこれは失敗しました。

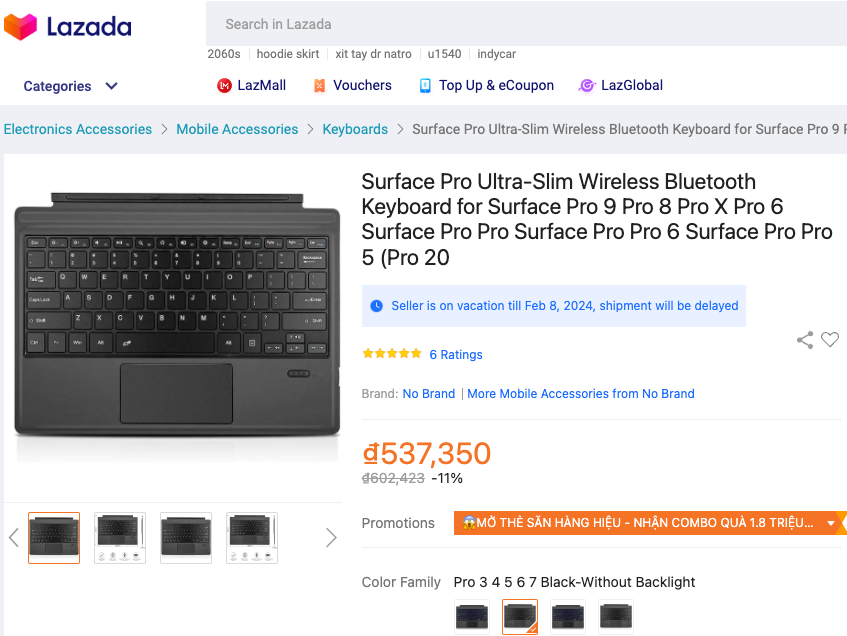

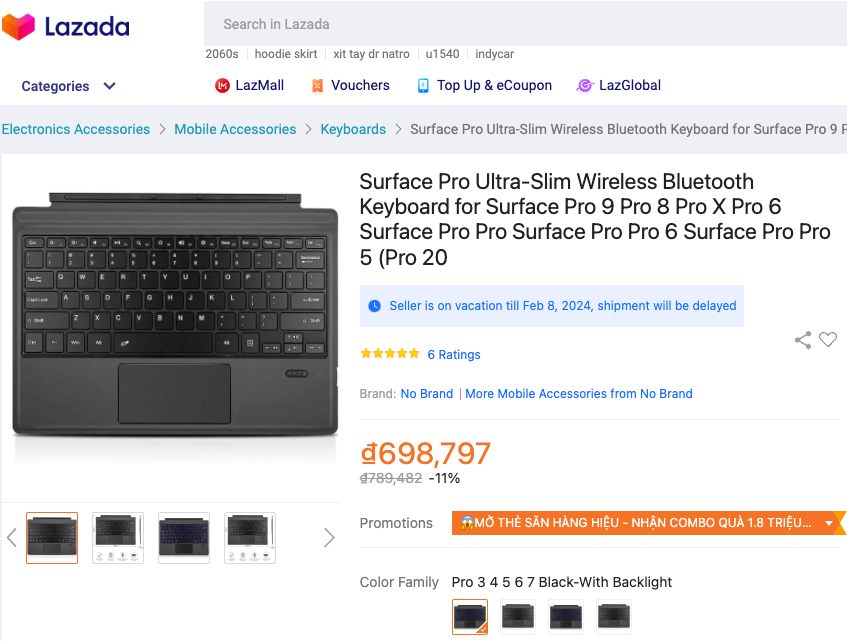

●バックライトなしのbluetooth接続・・・3300円

●バックライトありのbluetooth・・・4200円

こっちは15万VNDくらい高いです。日本円で差額900円くらいだったので試しに1つゲット。

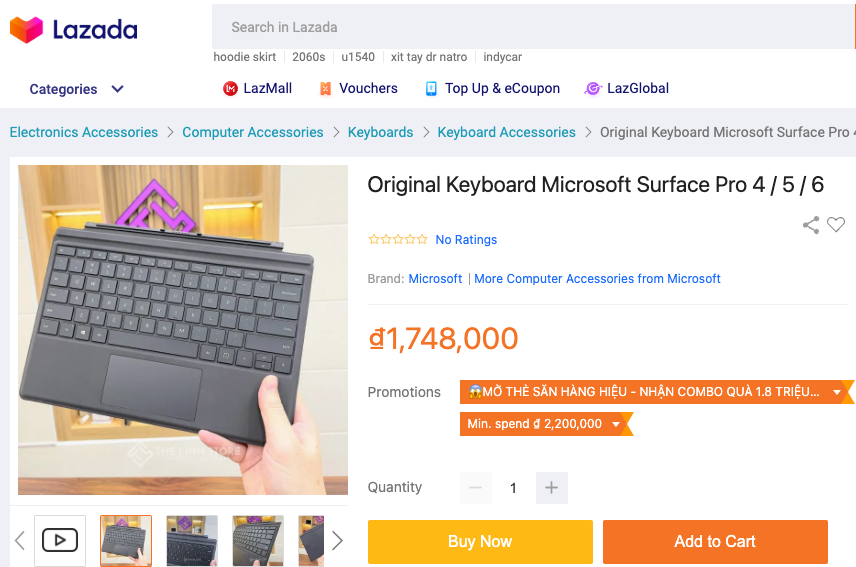

やっぱり英語キーボードの純正が一番

というわけで、いろいろとキーボードは検討したのですが、今のところ純正のサーフェイスのキーボードが一番です。理由は以下の通り。

- bluetoothではなく、物理接続のUSB接続なのでBIOS起動時などにも利用可

- トラックパッドのドライバーが使えて、マルチタッチで操作可能

- サードパーティー製の中華よりキーボードが押しやすい(すぐわかるレベル)

ということで、Lazadaでこのキーボードの中古品(程度良いらしい)を購入しました。お値段は、1万円くらいです。ちょっと高かったんですが、仕方ないです。このキーボードはもう廃盤っぽいらしいので。

- MicroSoft:Surface Pro タイプ カバー(LINK)

Surface ProのUSキーボードは日本では中古では入手しにくいですがベトナムでは結構流通しています。純正MSのタイプカバーキーボードは、タイプした感触は良いのですがキーストロークが浅いので少し慣れが必要です。しかし、bluetoothのサードパーティ製とは違い、キートップから滑るような感触はないので良いです。

これが壊れたら、Apple純正の英語版キーボードが候補ですね。てか、Surface Proはその形状から、分離式のキーボードもありかもしれません。いろいろ使ってみます。

お絵描きアプリをあれこれ検討する

今までは、タッチペンも持っていなかったしこれ系のソフトウエアはノーチェックです。macosでも探せば、あるんですね!

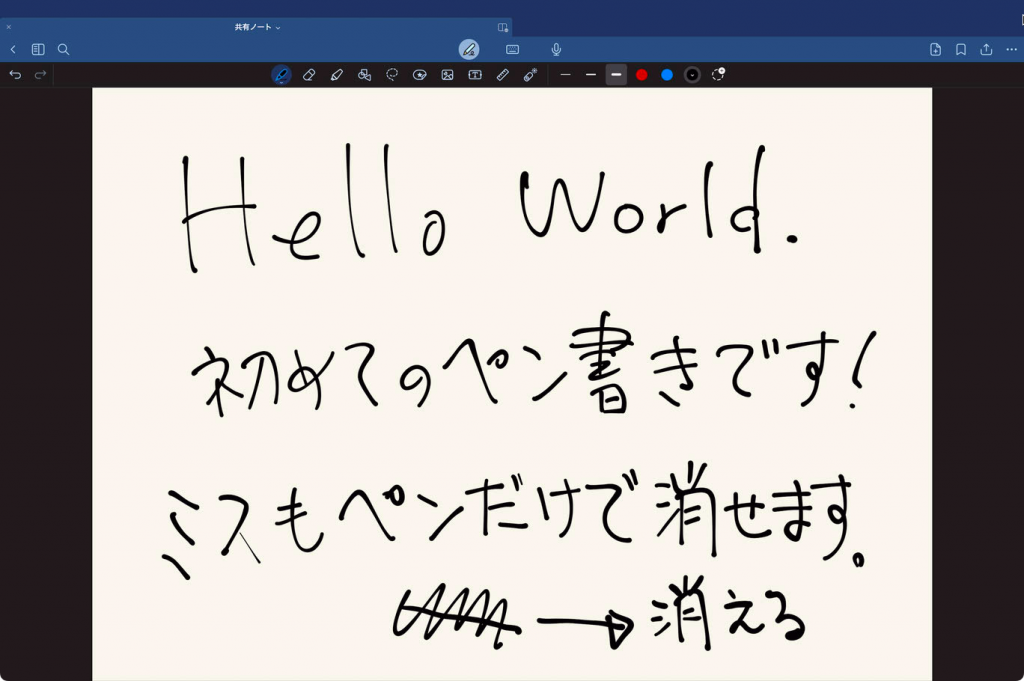

- Goodnotes6(アプリ版)・・・お気に入り

- WEB版のCanva(実際に書いたもの:LINK)

- Corel Painter

- MediBangPaintPro

- Inpaint

- Paint X

いろんなお絵描きアプリがありますが、どれが使いやすいのか検討中です。Goodnotes6の操作性が良いなって今のところ思っています。このアプリが優秀なのは、間違えたらペンのみで、消せるんですよね。

消したり、移動したりが便利なんですよね

まとめ

今回、なんとなくわかったのは以下となります。

・タッチパネル式のmacosは新鮮

・タッチペンは中華の互換品使ったが、なかなか描きやすい

・ちょっとツルツルすぎるので本格的に描くなら、画面にシートを貼ったほうが良さげ

・Surface Proの画面は、めっちゃ綺麗

・キーボードはMS純正のUSタイプカバーが良い

・WiFi、bluetoothはSurface Pro5や6では内臓のは使えず、外付けが必要

・なので、Surface Pro7かプラスがおすすめ

・macos12はメモリ4Gでもまぁ動くが、用途は限られる

・ので、Surface Pro5なら、8G i5モデル以上が欲しいところ

といった感じでしょうか。この端末をデバック機種として使うのか、メインmacと合わせて、液タブみたいに使うのはどうか?など利用方法を検討してみたいと思います。またはLinuxやChromeOSを入れて使うかもしれません。

あとがき

今回、勢いで5台も調達しましたが2台は友達へのプレゼントです。あと、いろいろ触ってみて思うのは、今後買うなら、surface pro7か7+がおすすめですね。ちょっと高いですが、CPU性能とかWiFi+bluetoothが標準のを使えるのはメリットです。どこかでゲットしてまたイジってみたいと思います。

著者にメッセージ

間違いのご指摘など、コメントじゃなくて、個人的にやりとりしたい場合はこちらからどうぞ。お返事が遅くなるときもありますが、ご了承を。